Tag: 分词

分词是自然语言处理中的一项重要任务,指的是将连续的文本按照一定的规则或算法拆分成具有一定意义的词或词语的过程。在中文文本中,由于汉字没有明确的分隔符,因此需要进行分词处理,以便进行后续的文本处理和分析。

分词在中文文本处理中非常关键,因为中文中的词是语义的基本单位,分词的准确与否直接影响到后续的语义分析、情感分析、信息检索等任务的效果。

分词算法有很多种,常见的分词方法包括:

- 基于词典的分词:使用预先构建好的词典来进行分词,将文本中与词典中词匹配的部分作为分词结果。这种方法简单高效,但无法处理未登录词。

- 最大匹配法:从文本的左边开始匹配最长的词,然后去掉已匹配的部分,继续从左边开始匹配,直到文本被切分完毕。这是一种贪心算法,适用于中文的分词。

- 隐马尔可夫模型(HMM):通过统计分析语料库,使用HMM进行分词,将概率最大的分词结果作为最终结果。

- 条件随机场(CRF):CRF是一种序列标注算法,适用于分词任务。通过学习标注语料库中的特征,可以获得更准确的分词结果。

- 深度学习方法:近年来,深度学习方法在分词任务上取得了很好的效果,例如使用循环神经网络(RNN)、长短期记忆网络(LSTM)、Transformer等模型进行分词。

分词是中文文本处理的第一步,因此在实际应用中,需要选择适合特定任务和数据的分词算法,以保证后续文本处理任务的准确性和效率。

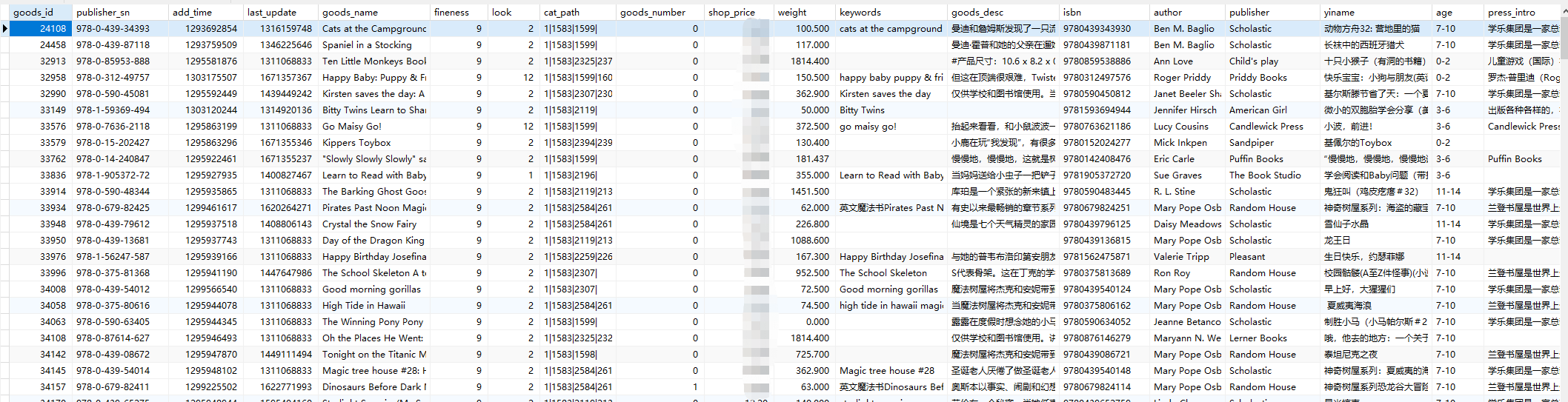

基于Elasticsearch 为电商提供商品数据大数据查询

前言 对于现代电商的产品,维度的多员花,与一套强大的搜索引擎,那是非常必要的。今天我们主要是描述我们在从事电商搜索引擎过程中的遇到的一些问题和经验分享。 过程 数据准备